OpenAI内部对话曝光!10万张显卡训练GPT-4.5曾出现“灾难性问题”?

4月13日消息,OpenAI 联合创始人兼 CEO 萨姆·阿尔特曼(Sam Altman)与 GPT-4.5 的3位核心技术人员进行了一场45分钟的深度对谈,首次披露了 GPT-4.5 训练过程中诸多不为人知的细节,引发了AI领域的广泛关注。

在今年2月28日发布的 GPT-4.5 是 OpenAI 史上推出的最贵最大语言模型,在3月6日已经面向所有 ChatGPT Plus 用户开放。

距离 OpenAI 启动 GPT-4.5 项目已经过了两年,这次 OpenAI 核心团队再回忆 GPT-4.5 的训练过程,为大家带来了超大的信息量!

在这场对话中,阿尔特曼率先抛出问题:“集群在从1万卡拓展到10万卡的时候,为什么遇到了这么多问题?”这一疑问也正是外界对 GPT-4.5 训练过程最为好奇的点之一。

OpenAI 首席系统架构师 Amin Tootoonchian 对此解释道,部分问题并不是大规模训练阶段独有的,而是原本就经常出现,但规模提升后就会变成灾难性问题。

他提到:“基础设施的问题是众所周知的,无论是故障率、故障类型还是故障总量都很高。10万卡集群是一个大规模的样本池,因此我们也发现了算力供应商都没有观察到的问题。网络是其中一环,单个加速器也会出问题。几乎所有组件都需要按预期工作,才能产生预期结果。”这意味着,在大规模集群中,任何一个小的组件故障都可能引发连锁反应,导致整个系统出现严重问题。

就好比一座庞大的城市,每个街区、每栋建筑都需要稳定运行,一旦某个关键设施出现故障,如供水系统或电力枢纽,就会影响到整个城市的正常运转。10万卡集群中的网络和加速器等组件,就如同城市中的关键设施,其稳定性至关重要。

目前,科技企业都在加快脚步布局AI赛道,AI训练对算力的需求刻不容缓。如果你有AI训练的需求,可以优先选择算力租用。比如,算力云平台就专为中小企业和高校实验室提供算力租用服务,目前有 RTX 4090/3090/2080Ti 等充足的显卡在香港、台湾多地域可租用。

采用算力云的显卡租用服务无需担心服务器基础设施的维护,用户可专注于大模型训练、推理等核心任务。

数据效率为什么被称为大模型突破的关键?在对话中,研究数据效率与算法的 Daniel Selsam 表示:“Transformer 架构在利用数据方面非常高效,它能很好地吸收和压缩信息,并实现泛化。但是,Transformer 架构从数据中获得洞察力的深度是有限的。当计算能力快速增长,而数据增长相对缓慢时,数据就会成为这种标准模式的瓶颈。”

也就意味着,随着计算资源(算力)不断增加,数据增长却跟不上步伐,使得数据成为了限制模型进一步提升的关键因素。

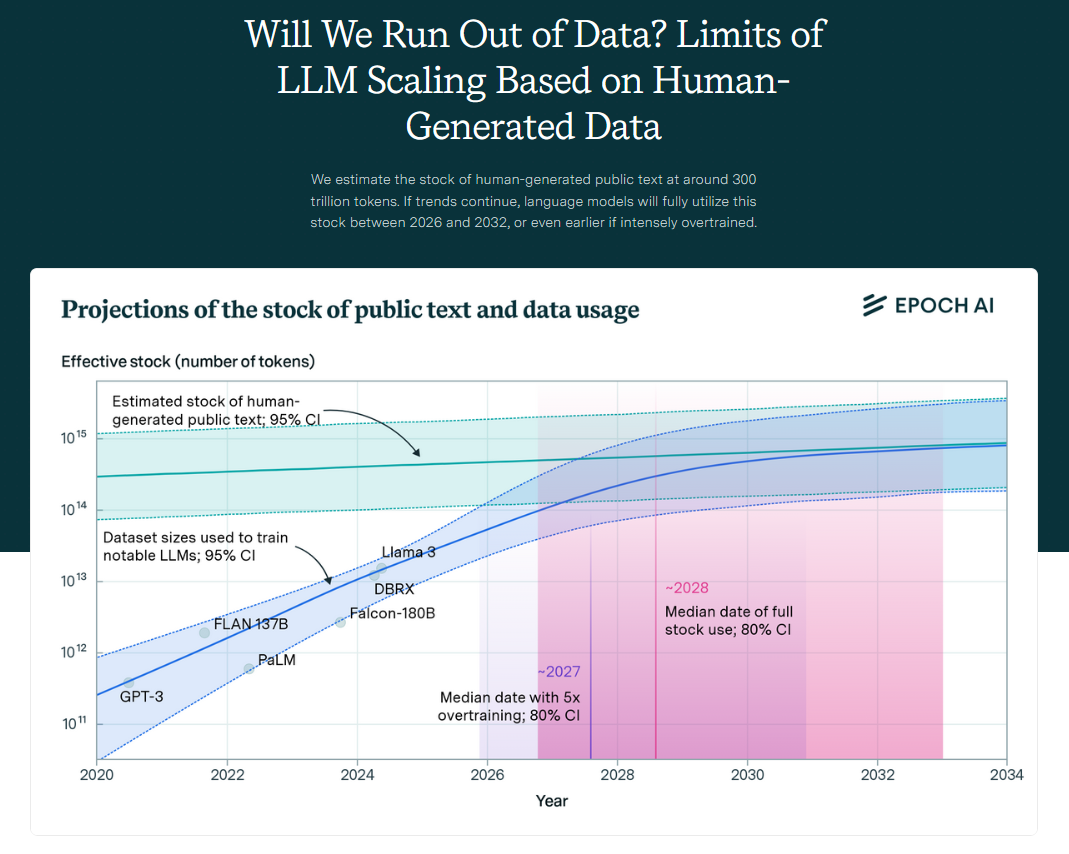

根据研究公司 EpochAI 2024年发布的预测,文本数据可能在2028年之前耗尽。自2020年以来,用于训练大语言模型(LLM)的“标记”(单词)数量虽已增长100倍,但可用互联网内容的增长速度缓慢,年增长率不到10%,而 AI 训练数据集的大小每年增长超过一倍,预计这两条曲线将在 2028 年左右交汇。

因此未来开发出能够利用更多算力从同样数量的数据中学到更多知识的方法,将成为提升模型能力的一种关键手段。

OpenAI 首席系统架构师 Amin Tootoonchian 也补充道:“为了实现下一个数量级的性能提升,我们必须解决若干已知但被暂时搁置的技术难题。在状态管理方面,由于所需计算资源已超出单集群承载能力,我们不得不转向多集群训练架构。”这表明,在追求更高性能的道路上,数据效率不仅关乎算法创新,还涉及到系统架构的调整和优化。

除了上述关键问题,对话中还透露了许多其他有趣的信息。比如,如今训练 GPT-4 级别模型,仅需5-10人即可完成,这得益于在完成 GPT-4.5 的过程中技术栈的巨大改进。

这次对谈让我们看到了 GPT-4.5 训练背后的艰辛与挑战,也让我们对大模型的发展有了更深入的理解。未来随着技术进步,相信这些问题都将得到更好的解决,推动AI技术迈向新的高度。

以上是算力云今日内容分享,感兴趣的朋友可以关注一下我们!